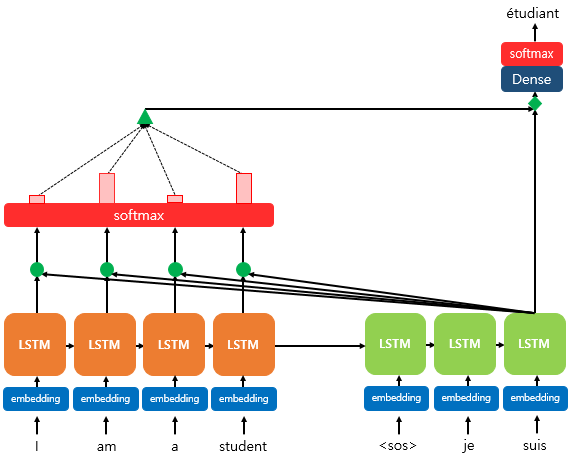

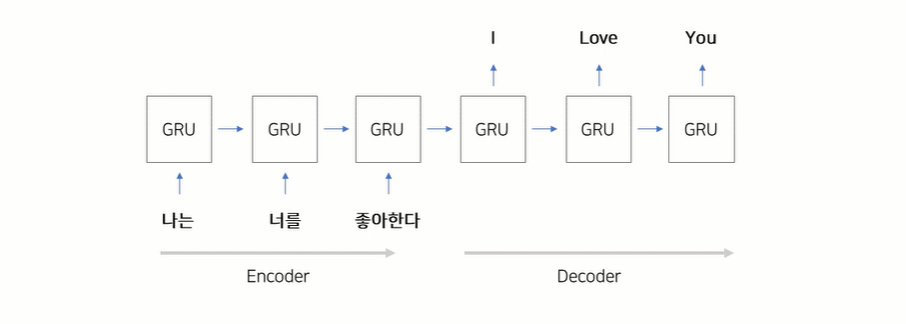

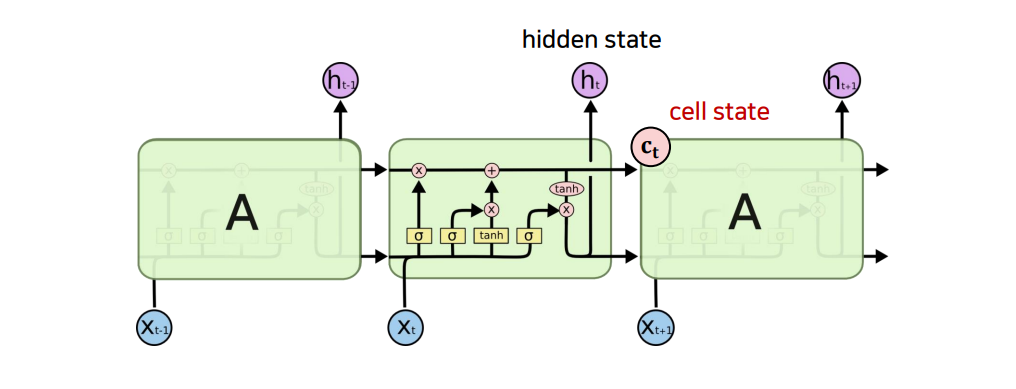

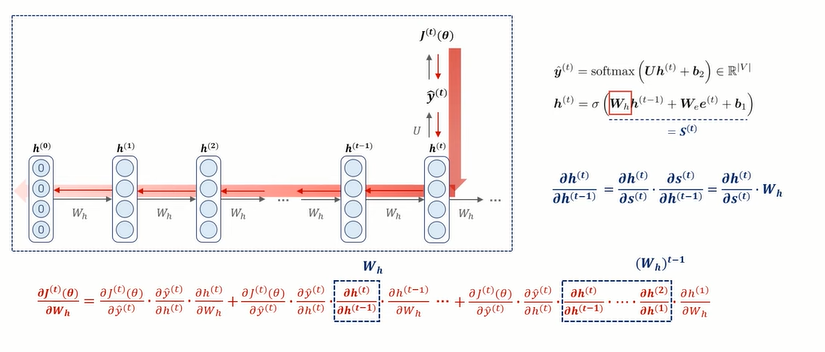

Attention 1. seq2seq의 한계 seq2seq란? 인코더 - 디코더라 불리는 두 개의 순환 신경망을 활용해 각각 입력 시퀀스를 벡터화하고 새로운 시퀀스를 출력하는 모델. ex) 기계번역 1) 압축에 따른 정보 손실 문제 인코더가 문장(시퀀스)을 길이에 상관 없이 하나의 고정된 크기의 벡터(Context Vecor)에 모든 정보를 압축하여 정보 손실 발생. 2) RNN의 기울기 소실 문제 기울기가 일정 수준 이하로 작아지면 장기 의존 관계 학습이 어려움. ex) 하이퍼볼릭 탄젠트 함수의 미분 → x가 0에서 멀수록 작아짐. 따라서, 입력 시퀀스(문장) 이 길어져도 출력의 정확도를 지킬 수 있는 기법 필요 → 어텐션! 2. 어텐션(Attention) 어텐션의 기본 아이디어 매 시점마다 전체 입력..