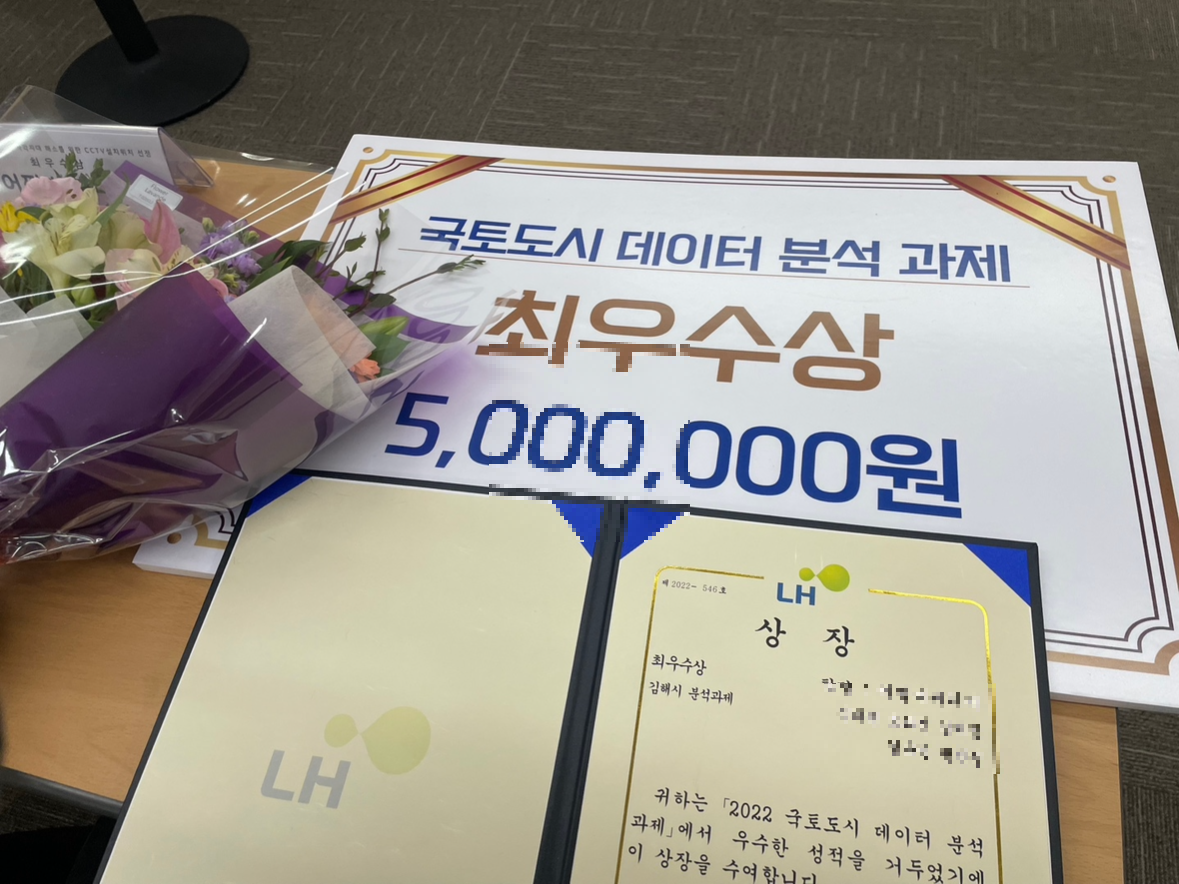

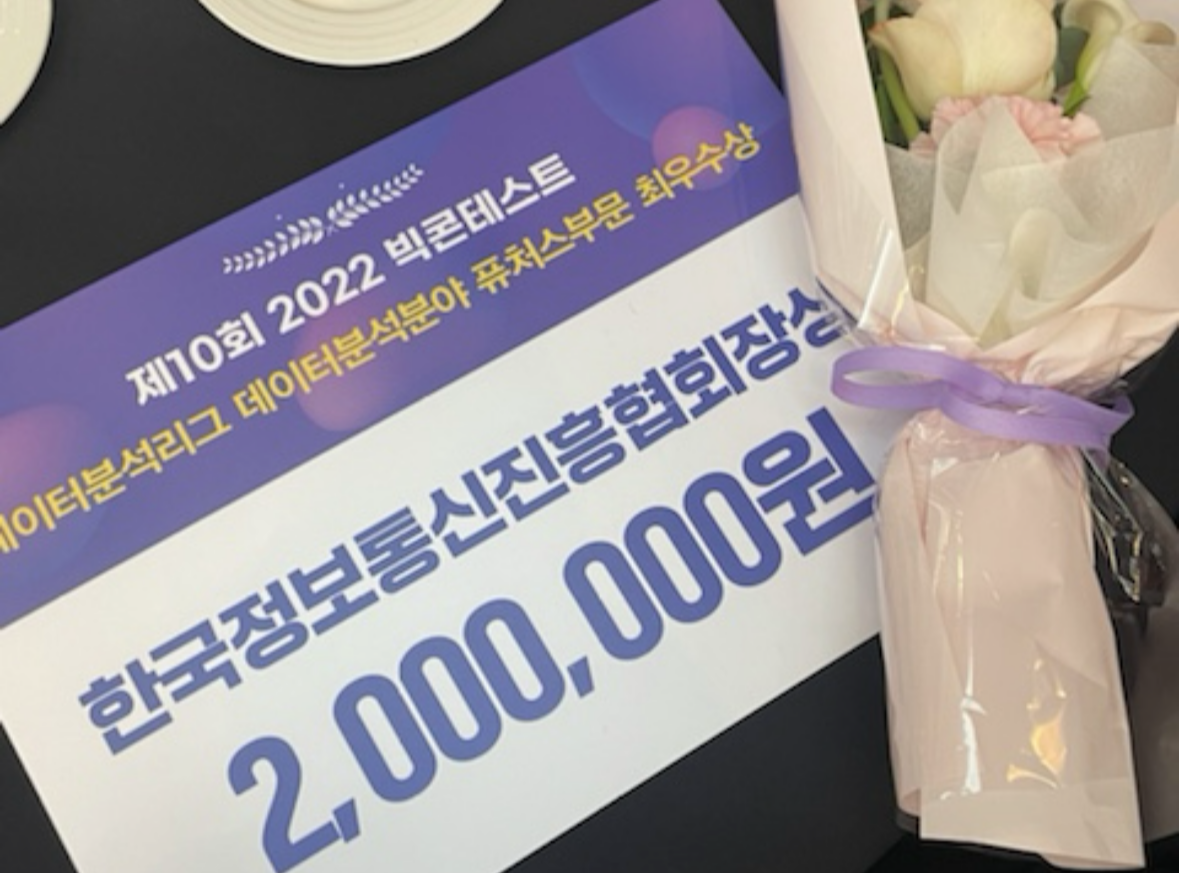

학회원들이랑 도전해 본 첫 데이터분석 경진대회! 그리고 대상 = 장관상을 받아 본 첫 경진대회! 라는 점에서 뜻깊은 대회이다. 💫참가한지도 3년 정도 지난 것 같은데 .. 아직도 장관상을 탔었다는게 실감나지 않는다.그리고 시상식에서 정말 많은 명함들을 주셨는데 너무 어렸던지라 어리바리 .. 데헷 큥 .. 을 시전하느라 원하시는 답변이나 요구사항을 잘 못받아먹었던게 조금 아쉽긴 하다. 지금 참가했더라면 나은 모습을 보여드릴 수 있을텐데 ㅜㅜ 1. 공모전 개요 나는 참가분야 중 데이터 분석 부문에 참가했다. 이후 시상식 자리에 가서 다른 부문 수상자분들을 만나뵐 수 있었는데, 거의 다 스타트업이나 실제 기업에서 TF팀으로 나오신 분들이 지원금 받기 위해서 참여하신 분들이더라는 .. 비하인드 ... 너무 ..